人类高层次的感知任务(如思考、计划和灵感等)依赖于人体多个器官的感觉信息的协同集成与整合。

其中,手势识别可以看作是一种相对简单的高层次感知任务,它可以被广泛地用于机器人和医疗保健等领域。

目前,手势识别主要通过使用机器学习方法对一些视觉信息(如照片、视频等)进行算法的处理来实现。

这类方法主要受限于视觉信息,容易受到一些不可预期的环境因素的干扰,例如遮挡或者变化的光线。

为解决这个问题,多模态识别(融合视觉和其它感觉模态)的方法已被提出。这类方法大多借助于当前市场上的一些可穿戴传感器来获取其它模态的一些信息,来提高识别精度,但是它仍然存在两个关键问题:

1、传统的可穿戴传感器大多是块状的、坚硬的,不能与人体表面形成紧密的接触,从而影响了人体运动信息采集的精度,尤其是在动态的场景下;

2、由于不同模态数据在维度和稀疏度上的严重不匹配,造成多模态融合的困难。

鉴于此,新加坡南洋理工大学陈晓东教授团队和澳大利亚悉尼科技大学路节教授团队合作,从人脑内部的多模态信息融合的学习机制出发,利用皮肤状可拉伸应变传感器获取人体运动信息,开发了一种新的视觉和体感融合学习方法,实现了高精度的手势识别。

相关成果发表在Nature Electronics,题目为“Gesture recognition using a bioinspired learning architecture that integrates visual data with somatosensory data from stretchable sensors”,其共同第一作者为南洋理工大学博士后王明和澳大利亚悉尼科技大学闫正。

这种新学习方法在定制的视觉-体感数据集上实现了100%的识别精度,并在视觉信息有噪音、曝光不足或曝光过度等非理想环境条件下仍然保持较高识别精度。该体系架构可用手势来进行机器人导航,结果表明在正常照明下的识别误差为1.7%,而在黑暗环境下的识别误差也仅为3.3%。

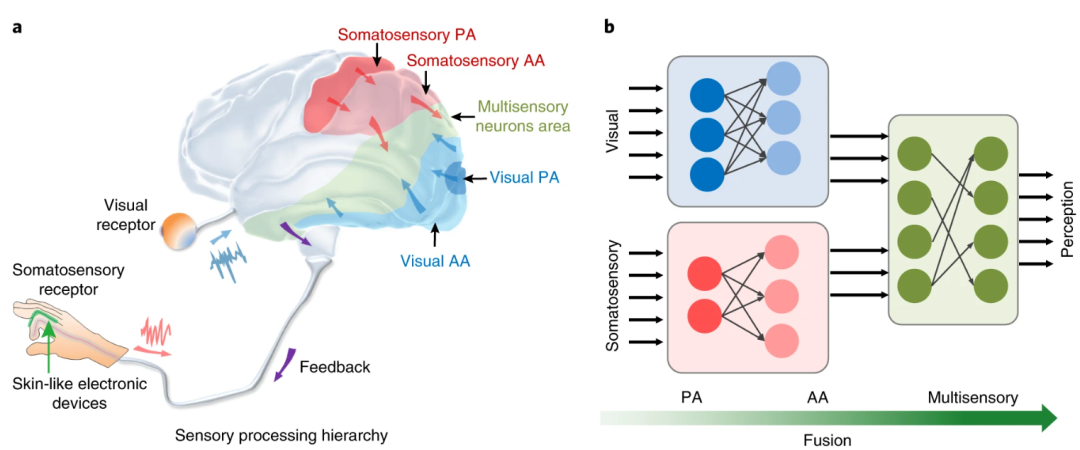

1、生物启发的视觉和体感融合的学习架构

受人脑内部的多模态信息融合的学习机制的启发,该团队开发了一种新的视觉和体感融合学习方法(图1)。该方法主要包括三个神经网络,第一个是卷积神经网络,用于处理早期的视觉信息;第二个神经网络用于处理早期的体感信息;第三个稀疏神经网络用于高效低能耗地融合视觉和体感信息。整体和局部的过程都尽可能地模拟着人脑的多模态信息融合的机制。

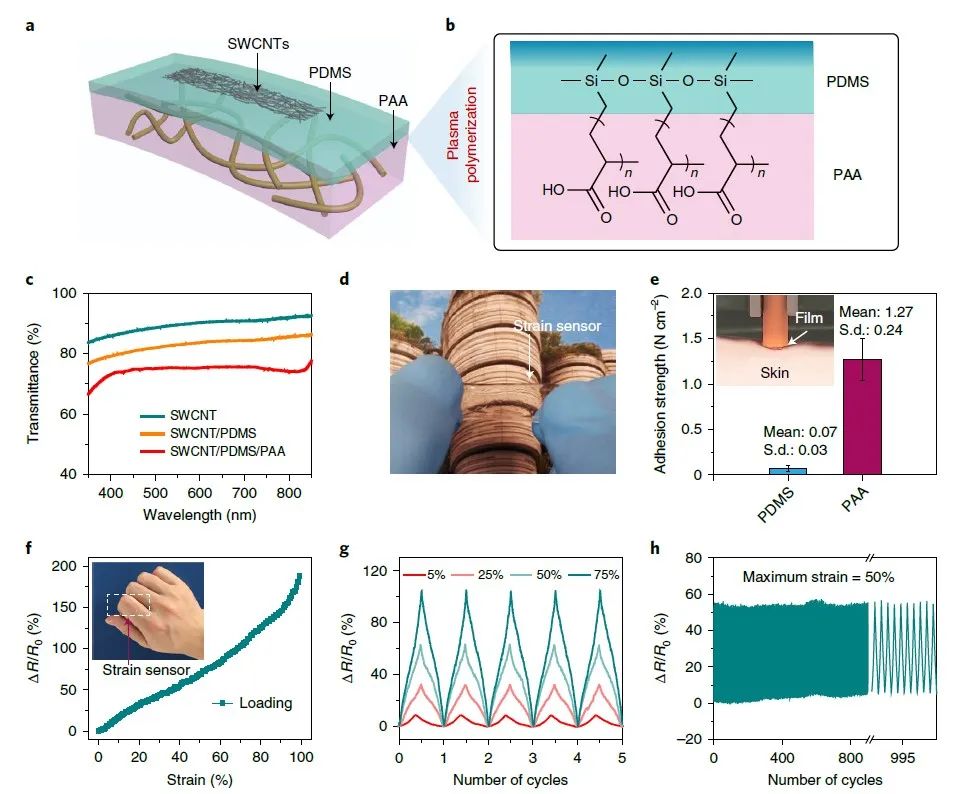

2、皮肤状可拉伸应变传感器

设计并制备了一种透明的、可粘贴的皮肤状可拉伸应变传感器来获取手指的体感信息(图2)。该可拉伸应变传感器呈现层状的堆叠结构,具有良好的透明度,并且可以直接粘贴在皮肤上,保证了在精确采集体感信息的同时使传感器本身对视觉图片信息的影响达到最小化。该传感器同时具有很好的拉伸性以及稳定性。

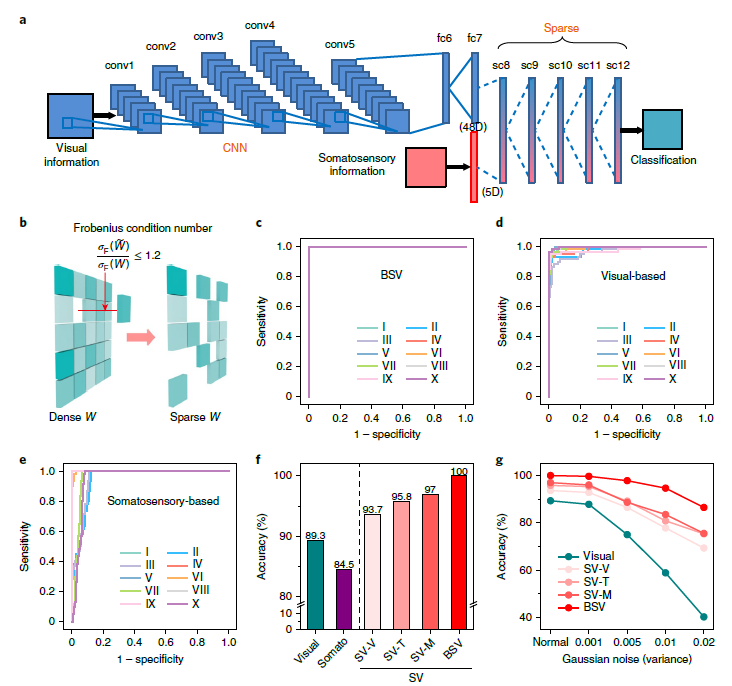

3、基于定制化的视觉-体感数据集的手势识别

为了验证生物启发的视觉和体感融合的学习架构,文中构建了一个新的视觉-体感数据集。并用该学习架构进行机器学习训练与识别。此外,文中还提出了一种基于弗罗贝尼乌斯(Frobenius)条件数的新的剪枝策略,用于获取稀疏神经网络来实现更加高效地数据融合。最终,该生物启发的视觉和体感的融合学习方法在定制化的视觉-体感数据集上实现了100%的识别精度(图3)。对比于单一模态识别和其它的多种多模态识别方式,该生物启发的融合学习方法可以得到最好的识别精度,并且当图片信息带有噪音、曝光不足或曝光过度等非理想因素时,仍然可以维持较高的精度。这种学习架构可以用手势来实现机器人导航,即便是在黑暗环境下(10 lux),识别误差也仅为3.3%。

文献链接: